Kecerdasan buatan (AI) telah mentransformasi berbagai aspek kehidupan kita, mulai dari mobil self-driving hingga diagnosis medis. Namun, di balik kemampuannya yang mengagumkan, sistem AI juga rentan terhadap serangan yang dikenal sebagai Adversarial Machine Learning. Serangan ini mengeksploitasi kelemahan dalam model AI, berpotensi menyebabkan kesalahan klasifikasi yang disengaja dan membahayakan keandalan sistem.

Artikel ini akan menjelajahi dunia Adversarial Machine Learning, mengungkap berbagai teknik serangan yang digunakan untuk mengecoh sistem AI dan dampaknya yang luas. Lebih lanjut, kita akan membahas strategi pertahanan penting yang dapat diterapkan untuk memperkuat model AI, meningkatkan ketahanan mereka terhadap serangan, dan memastikan keamanan serta keandalannya di berbagai aplikasi dunia nyata.

Daftar Isi

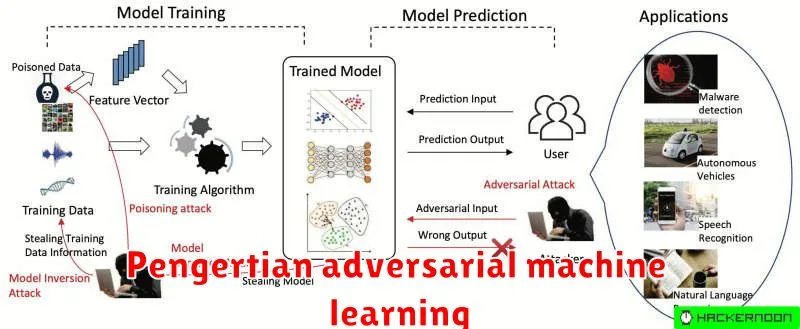

Pengertian Adversarial Machine Learning

Adversarial Machine Learning adalah bidang studi yang relatif baru dalam keamanan siber yang mengeksplorasi kerentanan model machine learning (ML) terhadap serangan adversarial. Serangan ini melibatkan manipulasi data masukan dengan cerdik untuk menyesatkan model yang telah dilatih, menyebabkannya membuat prediksi yang salah atau berperilaku tidak terduga.

Bayangkan sebuah model ML yang dilatih untuk mengenali gambar kucing. Dalam serangan adversarial, penyerang dapat menambahkan gangguan kecil yang tidak terlihat oleh mata manusia pada gambar kucing tersebut. Meskipun perubahannya tidak signifikan bagi kita, model ML yang telah dilatih mungkin keliru mengklasifikasikan gambar yang dimanipulasi sebagai sesuatu yang sama sekali berbeda, misalnya anjing.

Jenis-Jenis Serangan Adversarial Machine Learning

Serangan adversarial machine learning dapat diklasifikasikan berdasarkan beberapa faktor, seperti tujuan serangan, pengetahuan penyerang tentang model target, dan fase pembelajaran yang diserang. Berikut adalah beberapa jenis serangan yang umum:

1. Berdasarkan Tujuan:

- Serangan Pengelabuhan (Evasion Attack): Tujuannya adalah untuk mengecoh model yang sudah terlatih agar salah mengklasifikasikan input berbahaya.

- Serangan Peracunan (Poisoning Attack): Menyuntikkan data berbahaya ke dalam data latih untuk merusak model yang sedang dilatih, sehingga menghasilkan model yang bias atau tidak akurat.

- Serangan Ekstraksi Model (Model Extraction Attack): Mencuri model atau informasi penting dari model dengan mengirimkan query dan menganalisis responsnya.

2. Berdasarkan Pengetahuan Penyerang:

- Serangan Kotak Putih (White-Box Attack): Penyerang memiliki akses penuh ke model, termasuk arsitektur, parameter, dan data latih.

- Serangan Kotak Hitam (Black-Box Attack): Penyerang hanya dapat berinteraksi dengan model melalui input dan output, tanpa mengetahui detail internalnya.

- Serangan Kotak Abu-abu (Grey-Box Attack): Penyerang memiliki pengetahuan parsial tentang model, seperti arsitektur atau fitur yang digunakan.

3. Berdasarkan Fase Pembelajaran:

- Serangan Fase Pelatihan: Menyerang model selama proses pelatihan dengan memanipulasi data latih.

- Serangan Fase Inferensi: Menyerang model yang sudah terlatih dengan memanipulasi input data.

Penting untuk memahami berbagai jenis serangan adversarial machine learning untuk merancang dan menerapkan sistem AI yang lebih aman dan tangguh.

Contoh Penerapan Adversarial Machine Learning

Adversarial machine learning memiliki aplikasi yang luas, mulai dari meningkatkan keamanan siber hingga mendeteksi penipuan. Berikut adalah beberapa contoh penerapannya:

1. Pengenalan Gambar dan Objek:

Salah satu contoh yang umum adalah menyerang sistem pengenalan gambar dengan menambahkan “noise” yang tidak terlihat oleh manusia pada gambar. Misalnya, dengan sedikit modifikasi pada gambar panda, penyerang dapat membuat model AI salah mengklasifikasikannya sebagai gibbon.

2. Pemrosesan Bahasa Alami:

Dalam konteks pemrosesan bahasa alami, adversarial machine learning dapat digunakan untuk membuat teks “beracun” yang dirancang untuk membodohi filter spam atau sistem moderasi konten. Teks ini mungkin terlihat normal bagi manusia, tetapi mengandung pola tersembunyi yang dapat mengeksploitasi kerentanan dalam model AI.

3. Sistem Rekomendasi:

Platform e-commerce dan streaming sering menggunakan sistem rekomendasi untuk menyarankan produk atau konten kepada pengguna. Penyerang dapat memanfaatkan adversarial machine learning untuk memanipulasi rekomendasi ini, misalnya dengan memberikan rating palsu atau membuat profil pengguna palsu untuk mempromosikan produk tertentu.

4. Keamanan Siber:

Adversarial machine learning juga dapat digunakan untuk memperkuat sistem keamanan siber. Dengan melatih model AI pada berbagai jenis serangan adversarial, pengembang dapat mengidentifikasi dan memperbaiki kerentanan dalam sistem mereka sebelum dieksploitasi oleh penyerang.

Contoh-contoh ini hanyalah sebagian kecil dari penerapan adversarial machine learning. Seiring dengan berkembangnya teknologi AI, kita dapat mengharapkan untuk melihat lebih banyak aplikasi kreatif dan inovatif, baik untuk tujuan yang baik maupun jahat.

Strategi Pertahanan Adversarial Machine Learning

Melindungi sistem machine learning dari serangan adversarial merupakan hal yang krusial. Strategi pertahanan bertujuan untuk meningkatkan ketahanan model terhadap serangan adversarial. Berikut beberapa strategi umum yang digunakan:

1. Pelatihan Adversarial: Metode ini melibatkan pelatihan model pada data yang sudah dicampur dengan contoh adversarial. Dengan terpapar pada contoh serangan, model belajar untuk lebih robust dan tidak mudah terkecoh.

2. Deteksi Anomali: Strategi ini berfokus pada identifikasi input yang menyimpang dari distribusi data yang diharapkan. Input yang terdeteksi sebagai anomali kemudian dapat diblokir atau ditangani secara terpisah.

3. Preprocessing Input: Metode ini bertujuan untuk membersihkan input dan menghilangkan perturbasi yang mungkin disisipkan oleh penyerang. Contohnya adalah dengan menggunakan teknik denoising atau smoothing pada gambar.

4. Peningkatan Arsitektur: Merancang arsitektur model yang lebih robust terhadap serangan adversarial. Misalnya, dengan menggunakan lapisan “defensive distillation” atau menggabungkan beberapa model menjadi sebuah ensemble.

Strategi pertahanan yang optimal seringkali melibatkan kombinasi dari beberapa pendekatan. Penting untuk diingat bahwa bidang adversarial machine learning terus berkembang, dan strategi baru terus-menerus dikembangkan untuk melawan ancaman yang terus berubah.

Implikasi Adversarial Machine Learning

Adversarial Machine Learning membawa implikasi yang luas dan signifikan. Keberhasilan serangan adversarial dalam mengeksploitasi kerentanan model Machine Learning menimbulkan kekhawatiran serius tentang keamanan, kepercayaan, dan etika sistem AI.

Dalam sektor kritis seperti kesehatan, keuangan, dan kendaraan otonom, serangan yang berhasil dapat berakibat fatal. Bayangkan sistem diagnosis medis yang salah mengklasifikasikan tumor karena manipulasi gambar yang hampir tidak terlihat, atau mobil self-driving yang salah mengartikan rambu lalu lintas.

Lebih lanjut, ancaman adversarial mengikis kepercayaan publik terhadap sistem AI. Ketika model AI terbukti rentan terhadap manipulasi, orang menjadi ragu untuk mengandalkannya, terutama dalam pengambilan keputusan yang penting.

Oleh karena itu, pemahaman mendalam tentang implikasi adversarial machine learning menjadi krusial untuk mengembangkan strategi mitigasi yang efektif dan membangun sistem AI yang lebih tangguh, dapat diandalkan, dan dapat dipercaya.