Di era digital yang didorong oleh data ini, kemampuan untuk memproses data secara real-time menjadi sangat penting. Stream processing hadir sebagai solusi untuk tantangan ini, memungkinkan kita untuk menganalisis dan mengambil keputusan berdasarkan data yang terus mengalir tanpa henti. Apache Flink, sebagai salah satu framework stream processing open-source terkemuka, menawarkan kemampuan yang kuat dan skalabilitas tinggi untuk membangun aplikasi stream processing yang tangguh.

Artikel ini disusun sebagai tutorial lengkap bagi Anda yang ingin mendalami Apache Flink dan menguasai stream processing. Mulai dari pengenalan dasar hingga konsep tingkat lanjut, kita akan membahas berbagai aspek penting seperti arsitektur Flink, pemrosesan data streaming, windowing, state management, dan banyak lagi. Dengan mempelajari materi ini, diharapkan Anda dapat membangun aplikasi stream processing yang efisien dan handal menggunakan Apache Flink.

Daftar Isi

Pengenalan Apache Flink

Apache Flink adalah kerangka kerja open-source untuk pemrosesan data terdistribusi yang dirancang untuk menangani aliran data **real-time** maupun **batch**. Dikembangkan oleh Apache Software Foundation, Flink menawarkan platform yang kuat dan fleksibel untuk membangun aplikasi yang memproses data dengan latensi rendah dan throughput tinggi.

Flink menonjol karena kemampuannya dalam memproses data streaming secara stateful. Ini berarti Flink dapat menyimpan dan mengakses informasi tentang data yang telah diproses sebelumnya, memungkinkan untuk melakukan analisis dan agregasi yang kompleks pada aliran data secara efisien.

Beberapa fitur kunci Apache Flink meliputi:

- Pemrosesan Data Streaming dan Batch: Flink mendukung kedua paradigma pemrosesan data, menyediakan fleksibilitas untuk membangun berbagai aplikasi.

- Latensi Rendah dan Throughput Tinggi: Dirancang untuk performa, Flink dapat menangani jutaan peristiwa per detik dengan latensi sangat rendah.

- Toleransi Kesalahan: Flink memastikan bahwa aplikasi terus berjalan bahkan jika terjadi kegagalan node, menjaga konsistensi data.

- State Management: Flink menyediakan kemampuan pengelolaan state yang canggih, memungkinkan pemrosesan data streaming yang kompleks.

- Skalabilitas: Aplikasi Flink dapat diskalakan secara horizontal dengan mudah, memungkinkan untuk menangani volume data yang besar.

Arsitektur Apache Flink

Untuk memahami kemampuan Apache Flink dalam mengolah data stream secara real-time, penting bagi kita untuk menyelami arsitekturnya yang tangguh.

Arsitektur Flink dirancang secara berlapis, memberikan fleksibilitas dan skalabilitas tinggi. Lapisan terbawah adalah Deployment Layer, bertanggung jawab atas manajemen sumber daya dan eksekusi job. Di atasnya terdapat Runtime Layer yang menangani penjadwalan task, manajemen memori, dan komunikasi data antar node.

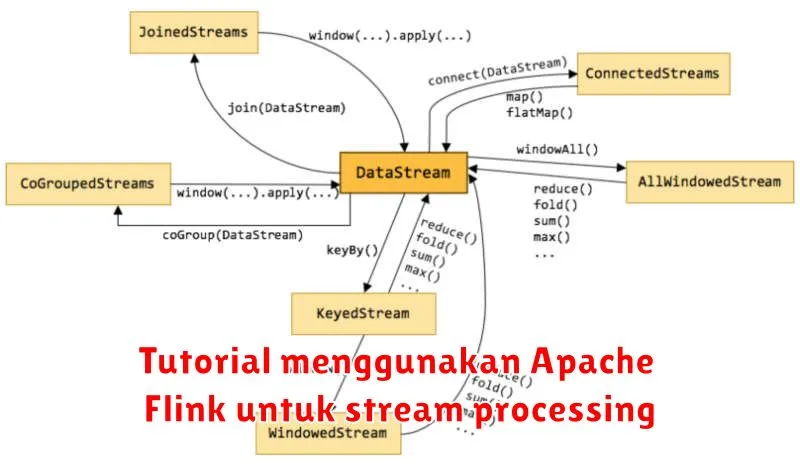

Selanjutnya, API Layer menyediakan antarmuka pemrograman yang beragam, termasuk DataStream API untuk stream processing dan DataSet API untuk batch processing. Terakhir, Libraries Layer memperkaya Flink dengan konektor data, format data, dan pustaka pemrosesan yang siap pakai.

Dengan arsitektur berlapis ini, Flink mampu menangani beban kerja stream processing yang kompleks dan berskala besar secara efisien.

Membangun Aplikasi Stream Processing dengan Flink

Membangun aplikasi stream processing dengan Apache Flink memerlukan pemahaman yang baik tentang konsep dasar stream processing dan arsitektur Flink. Artikel ini akan memandu Anda melalui proses langkah demi langkah untuk membangun aplikasi stream processing pertama Anda dengan Flink.

Langkah 1: Mendefinisikan Sumber Data dan Penerima Data. Pertama, Anda perlu mendefinisikan dari mana data streaming Anda akan berasal (sumber data) dan ke mana data yang telah diproses akan dikirim (penerima data). Flink menyediakan konektor untuk berbagai sumber data dan penerima data, seperti Kafka, RabbitMQ, dan sistem file.

Langkah 2: Mendesain Alur Pipelines. Setelah Anda memiliki sumber data dan penerima data, Anda perlu mendesain alur pipelines untuk memproses data streaming. Ini melibatkan penggunaan operator Flink untuk melakukan transformasi data seperti filtering, agregasi, dan windowing.

Langkah 3: Mengimplementasikan Logika Aplikasi. Dengan alur pipelines yang dirancang, langkah selanjutnya adalah mengimplementasikan logika aplikasi menggunakan API Flink. Flink menyediakan API tingkat tinggi seperti DataStream API dan Table API untuk memudahkan pengembangan aplikasi.

Langkah 4: Menjalankan dan Memantau Aplikasi. Setelah aplikasi Anda siap, Anda dapat menjalankannya di cluster Flink. Flink menyediakan alat pemantauan untuk melacak kinerja aplikasi dan mengidentifikasi potensi masalah.

Dengan mengikuti langkah-langkah ini, Anda dapat membangun aplikasi stream processing yang tangguh dan skalabel dengan Flink untuk menangani data real-time Anda secara efisien.

Contoh Kasus Penggunaan Apache Flink

Apache Flink adalah kerangka kerja pemrosesan aliran yang sangat serbaguna dan dapat digunakan untuk berbagai kasus penggunaan. Berikut beberapa contohnya:

1. Pemrosesan Data Real-Time: Flink sangat ideal untuk memproses aliran data real-time seperti data sensor, log server, dan transaksi finansial. Kemampuannya untuk menangani data dengan latensi rendah dan throughput tinggi menjadikannya pilihan tepat untuk aplikasi seperti deteksi penipuan, pemantauan sistem, dan analitik real-time.

2. Analisis Data Historis (Batch Processing): Meskipun dirancang untuk stream processing, Flink juga dapat memproses data historis dengan efisien. Ini dimungkinkan karena Flink melihat data batch sebagai kasus khusus dari data streaming. Flink dapat digunakan untuk tugas-tugas seperti analisis data historis untuk segmentasi pelanggan, analisis perilaku pengguna, dan lainnya.

3. Pipeline Data: Flink dapat digunakan untuk membangun pipeline data yang kompleks dan dapat diskalakan. Ini melibatkan pengumpulan data dari berbagai sumber, melakukan transformasi data, dan memuatnya ke dalam sistem penyimpanan atau aplikasi lain. Contohnya termasuk membangun pipeline ETL (Extract, Transform, Load) untuk gudang data atau pipeline data real-time untuk analitik.

4. Machine Learning: Flink mendukung machine learning dengan menyediakan library untuk membangun dan menjalankan model machine learning pada data streaming. Ini memungkinkan aplikasi seperti rekomendasi produk real-time, deteksi anomali, dan prediksi deret waktu.

5. Internet of Things (IoT): Flink sangat cocok untuk memproses dan menganalisis data yang dihasilkan oleh perangkat IoT. Kemampuannya untuk menangani data dalam volume besar dengan latensi rendah menjadikannya ideal untuk aplikasi seperti pemantauan peralatan, manajemen armada, dan kota pintar.

Tips dan Trik Mengoptimalkan Aplikasi Flink

Setelah mempelajari dasar-dasar Apache Flink dan cara membangun aplikasi stream processing, penting untuk memahami cara mengoptimalkan performa aplikasi Anda. Berikut adalah beberapa tips dan trik untuk membantu Anda memaksimalkan kinerja aplikasi Flink:

1. Pemilihan State Backend: Pilih state backend yang tepat sesuai kebutuhan aplikasi Anda. Untuk latensi rendah, pertimbangkan RocksDBStateBackend, sedangkan HashMapStateBackend cocok untuk state kecil dan latensi sangat rendah.

2. Serialisasi Data yang Efisien: Gunakan library serialisasi yang efisien seperti Kryo atau Apache Avro untuk mengurangi overhead serialisasi dan meningkatkan performa.

3. Pararelisme dan Pembagian Data: Tentukan tingkat paralelisme yang tepat untuk aplikasi Anda dan pastikan data didistribusikan secara merata di antara semua task untuk menghindari bottleneck.

4. Penanganan Watermark: Konfigurasikan watermark dengan benar untuk memastikan perhitungan time-based seperti windowing berfungsi dengan efisien. Watermark yang tidak akurat dapat menyebabkan keterlambatan dan hasil yang salah.

5. Checkpoint dan Recovery: Konfigurasikan checkpoint secara berkala untuk memastikan pemulihan yang cepat dari kegagalan. Sesuaikan interval checkpoint berdasarkan pertimbangan performa dan toleransi kehilangan data.

6. Pemantauan dan Performa Tuning: Gunakan alat pemantauan seperti Flink UI dan metrik untuk memantau performa aplikasi Anda. Identifikasi bottleneck dan sesuaikan konfigurasi seperti ukuran buffer, jumlah task, dan paralelisme untuk mengoptimalkan performa.

Dengan mengikuti tips dan trik ini, Anda dapat mengoptimalkan aplikasi Flink untuk mencapai performa maksimal dan memastikan kelancaran proses stream processing Anda.

Masa Depan Apache Flink

Apache Flink telah memantapkan dirinya sebagai mesin pemrosesan stream yang tangguh dan serbaguna. Dengan kemampuannya menangani data real-time dan batch, Flink terus berkembang dan berinovasi untuk memenuhi tuntutan lanskap data yang terus berubah.

Beberapa tren utama membentuk masa depan Flink, antara lain:

- Peningkatan Kemampuan Pemrosesan Data Berskala Besar: Flink akan terus meningkatkan skalabilitas dan performanya, memungkinkannya menangani volume data yang lebih besar dan lebih kompleks.

- Integrasi yang Lebih Erat dengan Ekosistem Cloud: Dukungan Flink untuk platform cloud akan semakin ditingkatkan, memudahkan penerapan dan pengelolaan di lingkungan cloud-native.

- Perkembangan Fitur Pemrosesan AI/ML: Flink akan terus mengintegrasikan fitur dan library AI/ML, memungkinkan pengguna membangun aplikasi streaming yang cerdas.

- Komunitas yang Aktif dan Berkembang: Komunitas Flink yang aktif dan terus berkembang akan terus mendorong inovasi dan adopsi Flink di berbagai industri.

Dengan fondasi yang kuat dan perkembangan yang berkelanjutan, Apache Flink berada di posisi yang tepat untuk terus menjadi pemimpin dalam dunia pemrosesan stream di masa depan.